Universitat Politècnica de Catalunya (UPC)

Resumen: Se presenta en este artículo una revisión de dos técnicas de metrología de superficies tridimensionales con múltiples aplicaciones: la estereoscopía activa por proyección de franjas y la imagen por tiempo de vuelo. En ambos casos se describe el principio básico de medida y las principales técnicas relacionadas, así como los principales prototipos y aplicaciones desarrolladas en ambos campos en el CD6 de la UPC.

Palabras clave: Lidar, tiempo de vuelo, estereoscopía, proyección de franjas, metrología óptica, imagen 3D.

Abstract: In this paper we present a review of two three-dimensional surface metrology techniques with multiple applications: active stereoscopy based on fringe projection and time-of-flight imaging. In both cases we describe their general working principle and the main related techniques, and the most important prototypes and applications developed in both fields at the CD6 of UPC.

Keywords: Lidar, time of flight, stereoscopy, fringe projection, optical metrogy, 3D imaging.

1. Introducción: Metrología tridimensional

Las diferentes técnicas de adquisición de imágenes tridimensionales de objetos reales nunca han estado tan cerca de nuestra vida diaria. Los teléfonos móviles de la próxima generación se anuncian con capacidades de reconstrucción 3D. El mundo del audiovisual estrena cada nueva gran producción en 3D; hay aplicaciones de móvil para convertir en 3D nuestras fotografías, y los hologramas y otras tecnologías varias están introduciéndose rápidamente en el mundo de la electrónica de consumo y en nuestro lenguaje para ofrecer más proximidad en la reproducción y registro de nuestro mundo 3D.

Más allá de estas aplicaciones audiovisuales en que el interés está en reconstruir una escena con apariencia tridimensional a partir de imágenes bidimensionales, jugando con nuestro sistema visual con diferentes técnicas de añadir profundidad a las imágenes, se han desarrollado diversas técnicas de metrología óptica que permiten reconstruir tridimensionalmente escenas y objetos extensos. El objetivo de la medida puede ser digitalizarlos para su edición virtual posterior aprovechando la información de volumen añadida, o reproducirlos en impresoras 3D, pero a menudo se utilizan con fines de detección y caracterización precisa de volúmenes, formas y propiedades superficiales, como la rugosidad. Estas informaciones tienen mucho interés en diferentes ámbitos industriales y biomédicos, y en el entorno audiovisual, en el que separar un objeto del fondo que lo rodea es a menudo muy relevante con fines de edición y procesado de la imagen. Una de las principales barreras que se establecen ante una determinada necesidad, sin embargo, es la dificultad de seleccionar la técnica de medición 3D óptima para la aplicación, de entre las diferentes posibilidades existentes. Igualmente, la adaptación a las necesidades de los usuarios, de las tecnologías existentes, incluso si están muy bien desarrolladas y disponibles comercialmente, puede no ser evidente, en especial si el formato no es generalista o la aplicación tiene una especificidad mínima. El problema nace de la existencia de diferentes técnicas de medición 3D sin contacto, ya que cada técnica de medida por medios ópticos es adecuada para una determinada aplicación, objeto, campo de visión o distancia de trabajo. Existe una enorme variedad de técnicas de metrología óptica capaces de entregar sin contacto una imagen tridimensional detallada de superficies de diferentes tipos. Así, es posible encontrar técnicas con resoluciones inferiores al nanómetro (la interferometría, o la microscopía interferométrica con detección de fase serían ejemplos). Otras técnicas se basan en la reconstrucción de superficies 3D a partir de la medida de conjuntos ordenados de puntos de luz, de los que se verifica la posición de mejor enfoque (perfilometría confocal o interferometría de luz blanca). Ahora bien, en el momento en que nos acercamos a formas con escalas del micrómetro al centímetro, y si además la aplicación pide realizar análisis de áreas grandes con velocidades importantes y/o en entornos poco colaborativos o incluso hostiles, el rango de técnicas se ve reducido notablemente. La intención de este artículo es presentar una breve revisión de las dos familias de técnicas más relevantes en el campo de la imagen 3D industrial, útiles en áreas extensas, capacitadas para hacer capturas rápidas, y con resoluciones variables pero en el rango del centímetro al micrómetro. La sección 2 presentará el principio de funcionamiento de dos de las principales familias de técnicas en este ámbito: la estereoscopía basada en proyección de franjas y las técnicas de tiempo de vuelo. En la sección 3 se presentarán ejemplos de aplicaciones y desarrollos que hemos realizado en el Centro de Desarrollo de Sensores, Instrumentación y Sistemas (CD6) de la Universidad Politécnica de Cataluña (UPC) en el ámbito de estas técnicas. Finalmente, la sección 4 presentará unas breves conclusiones respecto de las técnicas de metrología 3D de área extensa presentadas.

2. Introducción a las técnicas de metrología 3D de áreas extensas

2.1. Estereoscopía activa

El principio de la estereoscopía es conceptualmente muy simple, ya que es el que utiliza el sistema visual de la mayoría de los seres vivos. Con una única imagen 2D es imposible reconstruir la sensación de profundidad característica del mundo 3D, como podemos comprobar sólo con taparnos un ojo en un entorno que no conozcamos. En cambio, las diferencias en la percepción de dos imágenes del mismo objeto observadas desde puntos de vista «monoculares» ligeramente diferentes por dos detectores situados a una distancia conocida, permiten recuperar la información de profundidad del objeto con precisión. Estos detectores pueden ser nuestros ojos o bien, en aplicaciones de ingeniería, cámaras situadas a distancias conocidas con un número de píxeles variable. Llevada a la expresión más simple del experimento, una reconstrucción estereoscópica requiere, pues, de una pareja de cámaras que, desde diferentes posiciones y en ángulos de visión diferentes (pero conocidos), observen el objeto a reconstruir y permitan medir su posición a partir, esencialmente, de correlaciones entre las dos imágenes que pueden interpretarse como una triangulación entre los puntos correspondientes de las imágenes captadas (para ser precisos, lo que se suele aplicar es una reconstrucción de la altura basada en una configuración de triangulación conocida como geometría epipolar), a menudo partiendo de algún proceso de calibración previo. Dependiendo de la aplicación, sin embargo, puede aparecer el problema de la detección preliminar de cuáles son los puntos correspondientes de las dos imágenes que se emparejan. A menudo, por ejemplo, se buscan puntos destacados en la imagen que se detectan mediante algoritmos de detección de bordes o de ángulos, por ejemplo, y por lo tanto la densidad de puntos de muestreo queda limitada a las parejas de puntos correspondientes que se puedan identificar en ambas imágenes con fiabilidad. En aplicaciones en las que se persigue determinar reconstrucciones detalladas de las superficies a medir, a menudo se completa el sistema de estereoscopía con la proyección de algún tipo de patrón de luz estructurada, muy habitualmente un patrón sinusoidal de líneas blancas y negras, como se muestra en la figura 1. El papel de las líneas es hacer de «marcas» a distancia conocida que permiten obtener una multitud de puntos correspondientes entre ambas imágenes, y por tanto una reconstrucción 3D muy detallada, que permite extraer información de forma, volumen o rugosidad de la superficie medida a partir de las alteraciones en la forma de las líneas que introduce el objeto a reconstruir. Con esta tecnología es posible obtener topografías de superficies con millones de puntos de muestreo.

Existe un número considerable de variantes de esta técnica, desde el escaneo de la superficie con líneas de luz, muy adecuado para la reconstrucción 3D de objetos en cadenas de producción (y también a menudo basado en estereoscopía), o montajes con una única cámara y un proyector en donde la reconstrucción 3D se obtiene de un control cuidadoso de las geometrías de iluminación y observación existentes entre la cámara, el objeto y el proyector (figura 2). En todos los casos, se trata de una familia de técnicas sencillas y robustas, que más allá de situaciones específicas logran valores típicos de resolución axial entre 1 y 500 micrómetros, dependiendo del diseño de la configuración experimental, y en donde la resolución horizontal (entendida como la distancia entre puntos de medida sobre el objeto) queda entre 1 y 100 micrómetros con montajes experimentales formados por componentes disponibles a costes bajos. Una vez obtenida la topografía 3D, existen diferentes técnicas sencillas y rápidas para calcular volúmenes, rugosidades y distancias entre elementos de la muestra en muchas de las librerías de información de fuente pública (open source) disponibles en la red.

2.2. Técnicas de tiempo de vuelo

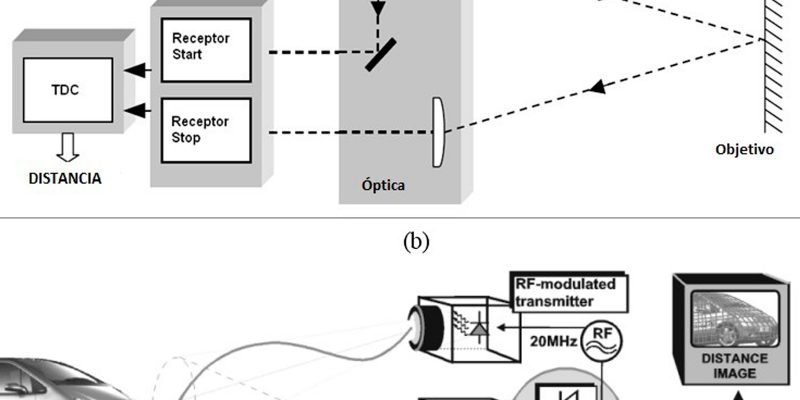

El tiempo de vuelo [1] es una técnica de medida que permite obtener medidas de distancias a partir de un dato conocido como es la velocidad de la luz. Dependiendo del campo de aplicación se denomina LIDAR (light detection and ranging), especialmente cuando se utiliza en ciencias de la atmósfera, o LADAR (láser detection and ranging), si hablamos de aplicaciones en el ámbito de los vehículos y la seguridad, o bien más genéricamente se habla de sistemas de tiempo de vuelo (TOF,time of flight). Las fronteras de esta terminología son, sin embargo, poco claras y seguramente se podrían proponer muchas otras definiciones. El hecho es que todos los sistemas TOF, LIDAR o LADAR utilizan una fuente de luz para iluminar un objeto o escena y captan parte de la luz reflejada para obtener directamente una medida de distancia. La técnica del tiempo de vuelo tiene dos variantes diferentes, una basada en luz pulsada [2] y otra basada en modulación de luz continua [3]. La técnica pulsada utiliza pulsos láser de duración muy corta para iluminar el objeto. La duración típica puede estar entre 1 ns y 10 ns. Un contador de tiempo de alta precisión (TDC, time-to-digital converter) cuenta el tiempo transcurrido entre el envío y la recepción del pulso reflejado en el objeto. La medida de distancia se obtiene directamente a través de la fórmula del movimiento rectilíneo uniforme utilizando la velocidad de la luz. La técnica modulada utiliza una fuente de luz continua modulada sinusoidalmente. Ésta ilumina el objeto y un detector mide la fase de la luz reflejada en él. Normalmente estos equipos utilizan luz difusa, como la generada por un LED de alta potencia. La expresión siguiente permite deducir el valor de distancia medido:

donde ƒ es la frecuencia de modulación de la fuente, c es la velocidad de la luz y θ es la fase medida. La distancia máxima medible está limitada, en este caso, por la frecuencia de modulación. Es común utilizar frecuencias entre 10 MHz y 20 MHz, las cuales ofrecen distancias de medida entre 7,5 m y 15 m [4]. La figura 3 presenta esquemáticamente una configuración de medida típica de cada una de las dos técnicas. Es importante notar que en un sistema de tiempo de vuelo la medida de distancia se obtiene directamente de la cuenta de tiempo, y que no son necesarias calibraciones ni largos cálculos posteriores, como sucede en el caso de la estereoscopía. Todo esto, sin embargo, se refiere a un sistema de medida puntual. Para obtener una imagen tridimensional completa, es decir, un número elevado de puntos medidos dispuestos en forma matricial, es necesario incorporar algún método de escaneo a parte del mismo sistema de medición del tiempo de vuelo. La figura 4 muestra ejemplos de imágenes tridimensionales obtenidas con esta técnica. Puede verse cómo la imagen está formada por una nube de puntos en un espacio tridimensional. La codificación de color da, visualmente, información sobre la distancia de cada una de las partes de la imagen en el dispositivo de emisión y recepción. Se trata, pues, de repetir el proceso de medición del tiempo de vuelo en muchos puntos de la escena.

Existen dos familias de métodos para medir imágenes de tiempo de vuelo. Por un lado, están los sistemas basados en una estrategia de escaneado [5] y, por otra, los basados en matrices de detectores [6]. Los sistemas de escaneo secuencial forman la imagen midiendo puntos únicos de manera secuencial a gran velocidad, y se aplican generalmente a sistemas TOF pulsados (Fig.3a).

La secuencia de iluminación es implementada mecánicamente mediante sistemas ópticos u optomecànicos como espejos galvanométricos, espejos con elementos micromecánicos (MEMS), deflectores acustoópticos, etc. Una de las principales ventajas de esta estrategia es que permite concentrar mucho la potencia del haz láser, por lo que maximiza la distancia a la que es posible obtener datos por encima del ruido del circuito de detección. Uno de los factores que limitan las prestaciones de medida de los sistemas de tiempo de vuelo es su capacidad de detectar haces reflejados de baja potencia, sea debido a la distancia entre el láser de iluminación y la escena o a la baja reflectancia de ésta. La baja divergencia de la luz láser en una imagen obtenida por escaneo permite mantener concentraciones de energía por unidad de superficie muy elevadas a distancias largas, por lo que es posible obtener medidas de decenas de kilómetros con resoluciones espaciales muy elevadas. La principal desventaja de esta tecnología, sin embargo, es el tiempo de medida de una imagen completa. Raramente es posible medir más de una imagen por segundo, lo que limita el uso de estos sistemas en aplicaciones en que aparecen objetos en movimiento. La otra estrategia que permite obtener imágenes por tiempo de vuelo son los sistemas basados en matrices de detectores (Fig.2b). Éstos utilizan un conjunto de detectores dispuestos en cuadrícula, en el que cada uno tiene capacidad de medida TOF, ya sea mediante la técnica pulsada o modulada. En este caso, los puntos de la imagen tridimensional son medidos simultáneamente utilizando cada uno de los detectores del conjunto. El conjunto de puntos medidos forma la imagen. La principal ventaja de esta estrategia consiste en la posibilidad de medir una gran cantidad de puntos de la escena simultáneamente, y conseguir así un número de imágenes por segundo muy elevado. Para conseguirlo es necesario que la fuente de luz ilumine simultáneamente cada uno los puntos que se miden, lo que implica dividir la potencia de iluminación entre todos los puntos a medir. El efecto que provoca es que el haz se expande sobre una superficie mucho mayor, en comparación con los sistemas de escaneado. En consecuencia, al disminuir la energía recibida en cada punto de la escena, la energía reflejada será también mucho menor, y del mismo modo el rango de distancias medible se reducirá, ya que llega mucha menos energía a los detectores. Normalmente, estos sistemas están limitados a unos 15 metros en ambientes de interior (sin luz solar). Existen equipos comerciales que pueden llegar a funcionar a distancias de hasta 100 m, aunque su coste es extremadamente alto ya que utilizan láseres de muy alta potencia. La principal ventaja de los sistemas basados en una matriz de detectores es que alcanzan velocidades de refresco de imagen muy elevadas, lo que los hace muy útiles en aplicaciones en que aparecen objetos en movimiento. Sin embargo, su uso en situaciones exteriores o para distancias superiores a 15 m es limitado, en la mayoría de aplicaciones.

3. Algunos ejemplos de aplicación

3.1. Estereoscopía: medidas in vivo del cuerpo humano

Una de las aplicaciones de más éxito de la estereoscopía combinada con proyección de franjas es la medida 3D del cuerpo humano, que tiene un papel muy importante en múltiples aplicaciones industriales relacionadas con los sectores del cine y los juegos de ordenador, la cirugía plástica, la dermatología, la medicina forense, la moda, la oftalmología, la ortopedia o la odontología, entre otros. En las últimas dos décadas ha habido un importante crecimiento de ventas en sistemas completos de digitalización 3D del cuerpo humano, con el desarrollo de nuevos métodos y herramientas para digitalizar y utilizar eficientemente las nubes de puntos obtenidas según la aplicación. En contraposición a los aparatos de medida por contacto mecánico, los aparatos ópticos se han impuesto, ya que ofrecen importantes ventajas, principalmente el hecho de proporcionar un escaneo in vivo sin contacto con la persona, una rapidez mayor en la medida y una gran precisión a la hora de medir detalles pequeños. Se han utilizado diferentes sistemas para medir la forma del cuerpo humano, íntegramente o de partes de interés preseleccionadas, que, como hemos visto, pueden clasificarse en los basados en proyección de patrones de luz estructurada (figura 1), los de escaneo mediante punto o línea láser (figura 2a) y otros de tipo estereoscópico basados en múltiples imágenes capturadas desde diferentes puntos de vista. Todos los sistemas tienen ventajas y puntos débiles dependiendo de los requerimientos de la aplicación concreta. Las técnicas estereoscópicas son técnicas pasivas que no requieren ninguna fuente de iluminación, pero que tienen como principales desventajas el intenso esfuerzo de computación necesario y la peor exactitud de la medida. Las otras dos tecnologías son de tipo activo (utilizan una fuente de iluminación específica) y comparten el mismo principio de medida 3D basado en triangulación a partir de la deformación de la luz proyectada en la superficie medida. La diferencia más significativa entre ambas técnicas se encuentra en la forma en que la luz se proyecta sobre el cuerpo humano, que puede ser un único punto o línea láser que deberá moverse mecánicamente a lo largo del cuerpo en el método de escaneo láser, mientras que en el caso del método de luz estructurada se proyecta un patrón de puntos o franjas extendido a todo el campo del cuerpo, como se puede observar en la figura 2b. Debido, pues, al proceso de escaneo secuencial que requiere la técnica de medición con láser, ésta resulta menos adecuada a la hora de medir toda una figura humana o partes de ésta que son de gran tamaño, ya que el tiempo de medición es de varios segundos y los movimientos inherentes a la persona debidos a la respiración o contracciones musculares involuntarias generan errores más importantes, siendo el tiempo de realización de la medida un parámetro crítico. En general, el método de escaneo láser puede resultar apropiado para la medida de pequeñas partes del cuerpo, como pies o manos, que se pueden mantener inmóviles durante el tiempo que dura la medida. Se trata, sin embargo, de un sistema idóneo para medidas de volumen y forma, para control de calidad en procesos en línea de producción. El sistema basado en la proyección de luz estructurada supera esta restricción ya que puede medir una superficie más grande en una sola adquisición o fase de iluminación. Sin embargo, en cuanto a la transferencia de las tecnologías en productos comerciales, cada una tiene una presencia diferente en el mercado. Con datos del 2009, a escala mundial el 49 % de los escáneres 3D comerciales de cuerpo humano se basaban en proyección de patrones de luz estructurada, el 32 % utilizaban el escaneo láser y el 19 % restante lo formaban aparatos basados en fotogrametría y otros tipos de técnicas no tan extendidas [10]. En particular, la tecnología de proyección de luz estructurada es mayoritaria desde un punto de vista comercial en Europa, en relación con el resto del mundo. Con datos de 2009, en Europa se producen casi el 64 % de estos productos a nivel mundial, frente al 25 % de América del Norte (EE.UU. y Canadá) y el 11 % del resto del mundo (principalmente Asia). Una gran parte de estos sistemas comerciales se han concebido específicamente para su uso en aplicaciones médicas, y muy particularmente en el caso de la cirugía plástica, en donde la relevancia de cuantificar formas y volúmenes es crítica. En este campo, el uso de equipos basados en la proyección de luz estructurada ha permitido poder planificar con más precisión las intervenciones de cirugía, llevar a cabo una comparación muy precisa entre antes y después de la operación o incluso poder simular el resultado de una operación antes de ser realizada, o seleccionar la prótesis óptima para el paciente. Un ejemplo típico es la generación de una prótesis de ojo o mama personalizada, para una persona que la ha perdido. Mediante el sensor de proyección de luz estructurada se escanea el otro ojo/mama del individuo, ya que es prácticamente idéntico al perdido, posteriormente se moldea con software para obtener su modelo virtual CAD (computer aided design), y finalmente se realiza físicamente mediante una herramienta CAM (computer aided manufacturing) [11]. Otros sectores industriales en los que esta tecnología ha tenido un gran impacto son el cosmético y el dermatológico, en donde los sistemas de proyección de luz estructurada sirven para estudiar y analizar con precisión y rapidez la topografía 3D de la piel en varias regiones del cuerpo humano [12][13][14]. A partir de la topografía 3D, estos sistemas integrales permiten cuantificar directa o indirectamente diferentes parámetros morfológicos y mecánicos de la piel, como la rugosidad, el volumen, el grado de envejecimiento, la anisotropía, la tensión, la firmeza o la plasticidad. En los últimos cinco años, en el CD6 de la UPC hemos trabajado muy activamente en el desarrollo de instrumentación para la medición 3D del cuerpo humano en aplicaciones industriales de los sectores cosmético y dermatológico. En concreto, el grupo ha desarrollado dos prototipos de medición 3D basados en la técnica de proyección de luz estructurada en combinación con la estereoscopía, en colaboración con socios industriales, del 2009 al 2013. El primer prototipo se desarrolló para evaluar objetivamente, in vivo y sin contacto, la eficacia de productos cosméticos formulados para reducir arrugas y volúmenes faciales, como las patas de gallo, las bolsas de ojos, etc., sobre los pacientes. Con este fin se diseñó y construyó un prototipo adaptado a los requerimientos de la empresa cliente, con respecto tanto a hardware como software. El prototipo integró dos configuraciones diferentes de medida: una de alta resolución que permitía medir cambios superficiales de unos pocos micrómetros, y una de media resolución, sensible a cambios más sustanciales, pero capaz de medir superficies de piel humana más grandes. Como ejemplo de uso práctico, la configuración de alta resolución se utilizó para cuantificar objetivamente la eficacia de un conjunto de cremas reductoras de patas de gallo, aplicadas a un grupo de pacientes conforme al protocolo estándar de evaluación de la empresa cliente. Colocando los y las pacientes adecuadamente, se registraron las topografías 3D de patas de gallo de ojo derecho e izquierdo en tres momentos temporales diferentes: al inicio del tratamiento, al cabo de un mes de tratamiento y después de dos meses de tratamiento. En la figura 5 se muestra un ejemplo de estas medidas 3D en la zona de patas de gallo al inicio y al cabo de un mes de tratamiento cosmético antiarrugas. La interfaz incorporó una herramienta que comparaba en tiempo real la imagen actual del paciente con la registrada en un tiempo pasado, y permitía al operador ajustar la posición del paciente de una manera precisa. A partir de las topografías 3D de la zona de patas de gallo, se calculan las rugosidades media (Ra) y total (Rz) en una longitud, que son las magnitudes típicamente utilizadas por la industria cosmética para cuantificar la efectividad de los productos cosméticos reductores.

El segundo prototipo de medición 3D desarrollado en CD6 comparte el mismo principio de medida que su predecesor, aunque es de dimensiones más grandes y con más complejidad optomecánica, ya que realiza medidas de zonas del cuerpo humano de (0,5 × 0,5) m2 y en un ángulo frontal de 180º, para aplicaciones de cirugía estética (figura 6). El prototipo cuenta con dos unidades de medida sincronizadas (cada una compuesta por un proyector y dos cámaras) que miden los datos 3D de los lados derecho e izquierdo del paciente, que finalmente son combinadas por software de una manera precisa para formar una topografía 3D completa. Además de la información geométrica tridimensional, el prototipo extrae el color rojo-verde-azul (RGB) de cada punto medido, y se obtiene como resultado un 3D con la textura real de color. En la figura 7 se muestra un ejemplo de topografía 3D de una cara obtenida con el escáner.

3.2. Tiempo de vuelo: desarrollo de cámaras de elevada resolución espacial

En el CD6, simultáneamente, hemos desarrollado un sistema de cámara de tiempo de vuelo que incorpora características combinadas de los sistemas basados en escaneo y de los sistemas basados en matrices de detectores. Esta combinación proporciona unas prestaciones únicas que no ofrece otro sistema en el mercado. El sistema está protegido a través de dos patentes y permite incrementar sustancialmente el rango de medida de los sistemas de matriz de detectores, manteniendo una velocidad de refresco de imagen elevada. Además, proporciona la capacidad de medir imágenes de resolución espacial muy alta, es decir, imágenes con una concentración de puntos muy elevada, que proporciona a la imagen un gran nivel de detalle. La resolución espacial es incluso reconfigurable por software dentro de una misma medición

El sistema desarrollado no puede medir distancias tan largas como las de los sistemas basados en el escaneo, ni posee velocidades de refresco tan elevadas como los sistemas basados en las matrices de detectores. Sin embargo, ofrece una mezcla de capacidades que lo hace único y le permite abordar aplicaciones que hasta ahora no estaban correctamente resueltas por ningún aparato comercial. Actualmente, esta tecnología se encuentra en las últimas fases de su desarrollo y aún no ofrece el máximo de sus capacidades. Sin embargo, se ha demostrado su viabilidad tecnológica a través de un prototipo especialmente diseñado para este fin. La figura 8 muestra diferentes vistas del aparato. Una de las ventajas más destacadas que ofrece esta tecnología respecto de las existentes es su capacidad para adaptar la resolución espacial de la imagen en función de las necesidades de cada momento. La velocidad de refresco de las imágenes es inversamente proporcional a la resolución espacial de la imagen medida. Cuanto más alta es la resolución de la imagen, menos velocidad de refresco. El incremento de resolución también perjudica el rango de distancia medible, ya que llega menos energía al detector. Por tanto, se hace necesario encontrar un compromiso entre la calidad de la imagen medida y la pareja velocidad-distancia. Los sistemas actuales no permiten configurar estos parámetros ya que son fijados por la misma construcción del aparato. En nuestro caso, estos parámetros son ajustables de forma dinámica durante el funcionamiento de la cámara. Esto puede ser extremadamente útil en aplicaciones avanzadas en las que se requiera aumentar el nivel de detalle de la medida según las condiciones de la escena. Del mismo modo, también puede servir para aumentar la velocidad de refresco cuando se requiera medir objetos con movimientos rápidos. Este cambio de propiedades de medición se puede adaptar de forma dinàmica según la información aportada por sensores externos. Por ejemplo, permite combinar la información procesada de una cámara 2D para identificar en qué situaciones conviene incrementar la resolución espacial de la imagen o aumentar su velocidad de refresco. Por otra parte, el sistema desarrollado en el CD6 ha incorporado un conjunto de innovaciones que le permiten ofrecer unas prestaciones superiores respecto a la tecnología de detección de pulsos. Normalmente, los sistemas de tiempo de vuelo emplean fotodiodos de avalancha (APD) o fotodiodos PIN como elementos de detección. Estos componentes suelen tener una ganancia del orden de 102. En cambio, el prototipo desarrollado utiliza un nuevo tipo de detector llamado fotomultiplicador de silicio (SiPM) que permite detectar cantidades de luz enormemente pequeñas, nominalmente del orden de fotones aislados con una ganancia del orden de 106 [15]. Este aumento de sensibilidad permite detectar pulsos reflejados de muy baja potencia, hace que la distancia medible sea mayor y permite el uso de láseres de menor potencia, más baratos y seguros. Las figuras 9 y 10 muestran una serie de imágenes medidas con el prototipo construido. En la primera se aprecia una escena compleja con multitud de objetos a diferentes distancias. La segunda muestra una pared donde se aprecia el aumento lineal de la distancia en la medida tridimensional. Estas muestras han sido tomadas a baja resolución, (64×48) píxeles. El prototipo construido no ha sido diseñado para capturar imágenes de alta resolución espacial, sino para demostrar la viabilidad de la tecnología y para la realización de pruebas de concepto. Sin embargo, se encuentra en construcción una segunda versión que permitirá escalar las capacidades actuales del sistema considerablemente. La tabla siguiente muestra un resumen de las capacidades esperadas del montaje actualmente en construcción.

Otra gran ventaja del sistema desarrollado es que supera el problema de los sistemas LIDAR concebidos para medir en ambientes exteriores, que tienen la desventaja añadida de tener que ser compatibles con condiciones atmosféricas adversas. La lluvia, la niebla, la nieve y el polvo pueden afectar negativamente a la fiabilidad del sistema, así como la luz solar intensa. En este caso, la tecnología de tiempo de vuelo pulsada ofrece soluciones mucho más fiables que la técnica modulada, la cual es muy inestable en ambientes exteriores. Los LIDAR de última generación incorporan tecnología que permite medir con fiabilidad en condiciones de tiempo adversas, empleando láseres en el espectro infrarrojo que interaccionan mucho menos con las moléculas de agua que contiene la atmósfera [16]. Por otra parte, hay que tener en cuenta también los efectos provocados por los diferentes fenómenos meteorológicos. Por ejemplo, la lluvia provoca que por cada pulso de láser enviado se produzcan múltiples subpulsos que llegan al detector provocados por las diferentes gotas de agua que el pulso original ha atravesado. Por tanto, es necesario utilizar circuitos de medida de tiempo con capacidad de medida de múltiples reflexiones de pulsos por un único pulso emitido [17]. En cuanto a las aplicaciones [18], se podrían destacar una gran variedad, a las que se están aplicando total o parcialmente las cámaras ya existentes: seguridad, vigilancia, visión artificial, guiado de vehículos, robótica, multimedia, creación de contenidos 3D, detección y seguimiento de objetos o transporte. Toda una batería de posibles aplicaciones en las que las cámaras de tiempo de vuelo ya se están aplicando y que esperamos que pueda mejorarse sustancialmente, entre otras propuestas tecnológicas, como las que hacemos desde el CD6.

4. Conclusiones

Existe una gran variedad de familias de técnicas ópticas de medida para superficies extensas que permiten obtener reconstrucciones 3D detalladas de los objetos observados. Entre éstas, en este artículo hemos destacado, por la generalidad de sus aplicaciones, la estereoscopía con proyección de franjas y la imagen de tiempo de vuelo. En el momento de seleccionar la técnica más adecuada para una aplicación concreta es necesario tener en cuenta las especificaciones de resolución, coste y tiempo disponible, tanto para la realización de la medida como para su procesado posterior. Las dos técnicas que hemos descrito permiten, con prestaciones diferentes y adaptables a la aplicación que se considere, dar respuesta a un gran número de problemáticas de interés industrial, científico y médico. Hemos presentado, además, los últimos resultados obtenidos en el CD6 de la UPC en ambas técnicas, que incluyen la construcción y el desarrollo de prototipos completos orientados a aplicaciones específicas en los ámbitos industrial y médico.

Bibliografía

[1] Forrester, P. A .; Hulme, K. F. «Laser rangefinders». Optical and Quantum Electronics, vol. 13, núm. 4 (1981), p. 259- 293.

[2] Maatta, K .; Kostamovaara, J .; Myllyla, R. «Profiling of hot surfaces by Pulsed time-of-flight laser range finder techniques ». Applied Optics, vol. 32, núm. 27 (1993).

[3] Xu, Z .; Schwa rte, R .; Heinola, H .; Buxbaum, B .; Ringbeck, T. «Smart Pixel – Photometric Mixer Device (PMD) New System Concept of a 3D Imaging-on-a-Chip “. A: 5th International Conference on Mechatronics and Machine Vision in Practice. Nanjing, 1998, p. 259-264.

[4] Lange, R .; Seitz, P .; Biber, A .; Schwa rte, R. «Time-of-flight range imaging with a custom solid-state image sensor ». A: Laser Metrology and inspection. Bellingham, SPIE, 1999. (Proceedings of SPIE; 3823).

[5] Milroy, M. J .; Bradley, C .; Vickers, G. W. «Automated láser scanning based on orthogonal cross sections ». Machine Vision and Applications, vol. 9, núm. 3 (1996), p. 106-118.

[6] Ailisto, H .; Heikkinen, V .; Mitikka, R .; Myllyla, R .; Kostamovaara, J .; Mantyniemi, A .; Koskinen, M. «Scannerless imaging Pulsed-laser range finding ». Journal of Optics A: Pure and Applied Optics, vol. 4, núm. 6 (2002), p. 337-346.

[7] Lange, R .; Seitz, P. «Seeing distances – fast time-of-flight 3D cámara ». Sensor Review, vol. 20, núm. 3 (2000), p. 212- 217.

[8]http://herkules.oulu.fi/isbn9514269667/html/c305.html

[9] Schwarz, L .; Mkhitaryan, A .; Mateus, D .; Navab, N. «Human skeleton tracking from depth fecha using geodesic distanced and optical flow ». Image and Vision Computing, vol. 30, núm. 3 (2012), p. 217 a 226.

[10] De Apuzzo, N. «3D Scanning of the human body». Presentation at Essilor [France], (2009).

[11] Stelzer, S .; Schreiber, S; Schoene, C. «utilisation of 3D Face Scanner in Medical Faculty ». 3D Modelling, Proceedings of Conference. París, 13-14 junio 2006.

[12]Jaspers, S .; Hopermann, H .; Sauermann, G .; Hoppe, U .; Lunderstadt, R .; Ennen, J. «Rapid in vivo measurement of the Topography of human skin by active imagen Triangulation using a digital Micromirror device ». Skin Research and Technology, vol. 5 (1999), p. 195-207.

[13] Perez, F .; Vera, S .; Lara, L .; Herrero Jover, J .; González Ballester, M. A .; Ares, M .; Royo, S .; Campderrós, L .; Panyella, D. «Quantitative evaluation of the effectiveness of cosmetic treatments and aesthetic surgical Interventions based on surface scans ». Computer Assisted Radiology and Surgery CARS 2012. Pisa, 27-30 junio 2012.

[14] Royo, S.; Suc, V.; Sergievskaya, I.; Atashkhooei, R .; Ares, M .; Segura, J .; Galcerán, J .; Panyella, D .; Cuello, J. «Photogrammetric fringe projection for in-vivo skin Topography measurements ». Libro de Actas de la 6ª Reunión Nacional de Optoelectrónica Optoel 09. Málaga, 2009, p. 295-298.

[15] Yamamoto, K .; Yamamura, K .; Sato, K .; Ota, T .; Suzuki, H .; Ohsuka, S. “Development of Multipixel Photon Counter: MPPC”. IEEE Nuclear Science Symposium. Conference Record, núm. 30-102 (2006).

[16] Schilling, B .; Barr, D .; Templeton, G .; Mizerka, L .; Trussell, C. «Multiple-return láser radar for three dimensional imaging through obscurations ». Applied Optics, vol. 41, núm. 15 (2002).

[17] Niclass, C .; Soga, M .; Matsubara, H .; Ogawa, M .; Kagami, M. «A 0.18μm CMOS SoC for a 100m-Range 10fps 200×96- Pixel Time-of-Flight Depth Sensor ». International Solid State Circuits Conference. Image Sensores, sección 27 (2013).

[18]Hansard, M .; Lee, S .; Choi, O .; Horaud, R. Time-of-flight cameras: Principles, methods and applications. Springer, 2012. (Springer Briefs in Computer Science; 1)

Comentarios